티스토리 뷰

Multi-co-training for document classification using various document representations: TF-IDF, LDA, and Doc2Vec

기내식은수박바 2019. 3. 26. 20:59논문

Abstract

- 문서 분류의 목적은 가장 적절한 레이블을 지정된 문서에 할당하는 것임.

- 문서 분류에서 가장 중요한 과제는 불충분한 레이블 정보와 구조화 되지 않은 희소 (sparse) 형식임.

- 준지도 학습 (SSL, Semi-supervised learning) 접근은 불충분한 레이블 정보 문제에 효과적인 방법이 될 수 있는 반면, 여러 문서 표현 방법에 대한 고려는 구조화 되지 않은 희소 형식를 해결할 수 있음.

- Co-training은 동일한 예시에 대해 Feature Subset이라는 점에서 다양한 관점을 이용하려고 시도하는 유명한 SSL 방법임.

이 논문에서 우리는 문서 분류 성능을 향상시키기 위해 Multi-co-training (MCT) 를 제시함.

- 분류에 대한 Feature Set의 다양성을 늘리기 위해, 우리는 세 가지 문서 표현 방법들을 사용하여 문서를 변형 (Transform) 함 :

- Bag-of-Words 기반 TF-IDF (Term Frequency-Inverse Document Frequency)

- LDA (Latent Dirichlet Allocation) 기반 Topic 분포

- Doc2Vec (Document to Vector) 으로 알려진 신경망 기반 문서 임베딩

- 실험 결과들은 제시된 MCT가 파라미터 변화에 견고하고 다양한 상황에서 기준 (Benchmark) 방법보다 나은 성능을 발휘한다는 것을 증명함.

1. Introduction

- 문서 분류는 텍스트 마이닝의 주요 업무 중 하나이면서 스팸 필터링, 감성 분석 같은 일부 방법에 사용되고 있음.

- 문서 분류에는 두 가지 주요한 과제가 있음 :

- 불충분한 레이블 정보

- 최적의 표현 방법의 부재

- 문서 분류에서 어떠한 체계적이고 자동화된 과정도 수 많은 문서들에 클래스 레이블을 할당하면서 동시에 분류 모델을 갱신할 수 없음.

- 한편, 수 많은 다른 분류 방법들에서 일단 새로운 Dataset을 확보하면, 그 데이터의 클래스 레이블은 자동적으로 결정됨.

- 예를 들어, 통신 산업의 고객이탈 분류에서, 클래스 레이블들 (남는지, 떠나는지) 은 고객의 신분 (Status) 이 주기적으로 바뀌기 때문에 자동적으로 결정될 수 있음.

- 게다가, 금융 산업의 일일 주식 시장 예측에서, 업무의 클래스 레이블인 특정 지분 변동 가격도 또한 그날 시장이 마감 됐을 때 자동적으로 결정됨.

- 그러나, 문서들의 레이블 할당은 인간 노동 집약적 (Human-labor Intensive) 이고, 소비되는 시간과 비용적인 측면에서 효율적이지 못함.

- 더욱이, 문서가 다양한 길이를 가진 단어들의 리스트이기 때문에, 추가 분석을 위해서 고정된 크기의 수치 벡터로 변형되어야 함.

- 비록 TF-IDF, 그리고 최근에 제시된 분산 표현 기반 신경망과 같은 문서 표현 방법들이 사용 가능하지만, 모든 텍스트 분석 업무에 있어서 다른 방법 보다 더 좋은 성능을 발휘하는 문서 표현 방법은 없음.

일부 레이블 된 Example과 레이블이 없는 많은 양의 Example이 사용 가능할 때, 분류 수행을 향상시키기 위해 SSL을 사용하는 것을 하나의 방법으로 고려할 수 있음.

- SSL에서, 하나의 클래스에 속한 Example들은 하나의 분포로부터 생성된다고 가정함.

- 따라서, 비록 레이블이 없는 Example들이 명시적으로 구별 기능을 학습하도록 분류 모델을 돕는 데 사용될 수 없지만, 이 레이블이 없는 Example들은 다양한 클래스들의 데이터 분포 추측에 도움을 주기 위해 사용될 수 있음.

- 결국, 이 레이블이 없는 Example는 레이블이 있는 Example만을 바탕으로 얻은 경계와 비교하여 향상된 클래스 경계를 얻을 수 있도록 도움을 줌.

- 일부 전략들은 학습 알고리즘에서 SSL 개념을 구현해옴. 자가학습 ( Self-training [ST] ) 은 레이블이 있는 Example들과 현재 Classifier만을 사용하여 레이블이 없는 테스트 Example을 사용하는 Classifier를 구성했음.

- 만약 한 클래스에 대한 레이블이 없는 Example의 우도 (가능도, Likelihood) 가 충분히 높다면, 예측된 클래스 레이블을 가지고 레이블이 있는 Dataset에 포함됨. 그런 다음, 새로운 Classifier는 확장되고 레이블이 있는 Dataset을 바탕으로 훈련됨.

- 이러한 절차는 레이블이 없는 모든 Example이 사용 가능한 클래스 중 하나로 분류될 때까지 반복됨.

- 반대로, 생성 모델들은 레이블 되고 레이블이 없는 Example을 바탕으로 기초적인 데이터 생성 함수를 추측하려고 시도함.

- 모델들은 레이블되고 레이블이 없는 Example의 사후확률을 최대화하여 가장 적절한 분포 매개변수들을 결정하는데 사용될 수 있음.

- 그래프 기반 SSL은 특정한 Dataset이 Node (Example) 와 Edge (노드들 사이의 관계, 유사성 또는 거리) 을 사용하여 표현될 수 있다는 가정을 바탕으로 함.

- 일단 그래프가 생성되면, 레이블 정보는 레이블이 없는 Example을 적절한 클래스 레이블로 할당하기 위해 그래프를 통해 전파됨.

SSL 방법들 중에서, Co-training은 데이터를 다양한 관점에서 고려 한다는 점에서 매우 주목할만 함.

- Co-training의 전제는 데이터의 모든 중요한 특성들이 하나의 View로 관찰될 수 없다는 것임.

- 일부 특성들은 하나의 View를 이용하여 쉽게 이해될 수 있지만, 반면에 일부 다른 특성들은 다른 View를 사용하여 포착될 수 있음.

- 따라서, 특정한 Dataset의 Feature Set이 두 개의 Subset으로 나누어 질 수 있다면, 두 개의 Classifier는 독립적으로 하나의 Feature Set만을 바탕으로 훈련됨.

- 이 Classifer들을 Model A, Model B라고 가정해보겠음. 분류 모델들은 다음과 같이 서로를 가르치면서 진화함:

- Model A가 레이블이 없는 Example의 예측에 대하여 매우 신뢰도가 높은 반면 Model B의 신뢰도는 낮다면, 이 인스턴스 (Instance) 는 Model A에 의해 예측된 레이블을 가지고 Model B의 training set에 추가됨.

- 반대의 경우 또한 마찬가지로 발생함.

- 다른 분류 모델의 도움을 받아, 각 모델은 독립적으로 학습될 수 없는 Dataset의 특성들을 배울 수 있음.

- Co-training 성공의 주요 지표는 Dataset의 Feature가 독립적인 Subsets로 나눠질 수 있는지의 여부임.

- 만약 특정한 Dataset의 Feature들이 하나의 View로부터 생성되었다면, Feature Set을 나누는 것은 분류수행을 향상시키는데 도움이 될 수 없음.

- 반대로, Feature가 Object (One View) 의 텍스트 설명과 그 이미지 (Another View) 같은 서로 다른 View를 사용하여 자연히 생성되었다면, Co-training 방법은 분류 수행을 향상시키이 위해 레이블이 없는 Example을 효과적으로 사용할 수 있음.

우리는 Co-training 알고리즘이 훈련되는 방식에서 영감을 얻었으며, 다른 문서 표현 방법들이 다양한 텍스트 마이닝 업무들에서 자신들의 방법들의 효율성을 설명해오면서, 우리는 문서 분류에 있어서 Multi-co-training (MCT) 방법을 제시함.

- 우리의 방법에서는 문서들을 세 가지 표현 방법을 사용하여 나타냄 :

- TF-IDF (Term Frequency-Inverse Document Frequency)

- LDA (Latent Dirichlet Allocation)

- Doc2Vec (Document to Vector)

- TF-IDF 표현은 간단히 말해서 문서는 단어들의 집합이라는 가정과 연관된 Bag-of-Words 철학이 바탕임.

- 따라서, 그 문서는 각 단어의 상대적인 중요성을 계산 (즉, Corpus에 있는 단어의 대중성과 문서에 있는 단어의 빈도수를 고려하여) 하여 벡터화 될 수 있음.

- LDA는 본래 Topic 모델링을 위해 개발되었음. Topic 모델링의 주된 목적은 Corpus에 침투해 잠재 Topic들을 발견하는 것임.

- 일단 LDA가 훈련되면 두 개의 Output이 생성됨 :

- 토픽 별 단어 분포 (Word Distribution per Topic)

- 문서 별 토픽 분포 (Topic Distribution per Document)

- 후자는 단어 빈도수와 의미 정보 ( 토픽 구조 [Topic Constitution] ) 모두를 고려하는 또 다른 문서 표현으로 간주할 수 있음.

- Doc2Vec은 세 가지 문서 표현 방법들 중 가장 최신 기술이며, 이 방법은 Word2Vec의 확장판임.

- 단어는 하나의 벡터로 간주되며, 벡터 원소 값들은 Word2Vec 표현에서 실제 숫자들 (Real Numbers) 임.

- Word2Vec의 가정은 단어의 원소 값들이 Target 단어 주변에 있는 다른 단어들의 값에 영향을 받는다는 것임.

- 이 가정은 신경망 구조에 의해 해석되고 (연속적인 Bag-of-Words 또는 Skip-gram), 망 가중치는 관측된 Example를 학습하여 조정됨.

- Doc2Vec은 Word2Vec을 단어 수준에서 문서 수준으로 확장함. 각 문서들은 단어들의 공간처럼 동일한 공간에서 자신들의 벡터 값들을 가지고 있음.

- 따라서, 단어와 문서들의 분산 표현은 동시에 학습됨.

- 일단 Corpus 내 문서들이 세 가지 표현 방법을 이용하여 표현됐다면, 우리는 각 표현 방법을 바탕으로 세 가지 분류모델을 훈련할 것임.

- Co-training에서 세 가지 모델 중 하나에서 상당히 높은 예측 신뢰도를 가진 문서는 신뢰도 있게 예측된 레이블을 가지고 나머지 두 모델들의 Training Set에 추가됨.

- 제시된 MCT 방법을 증명하기 위해서, 우리는 신뢰성있게 레이블이 있는 훈련 Example의 비율, 표현 차원, 데이터 의존 파라미터을 달리 하여 실험들을 실시함.

2. Literature Review

- 문서 분류가 주된 텍스트 마이닝 작업들 중 하나가 되면서, 관련된 많은 연구들이 오늘날 상당한 진행을 보여옴.

- 이 연구에서, 우리는 문서 표현 방법들에 초점을 맞추는 동안 일부 대표적인 연구들을 간단하게 리뷰함.

오늘날, TF-IDF는 다양한 문서처리 작업들 중 가장 흔하게 채택되는 문서 표현 방법이 되었음.

- 이 방법은 다음에 나오는 두 가지 기준에 따라 문서 내에 있는 각 단어에 가중치를 부여함 :

- 특정한 문서 내 단어의 사용 빈도 (TF, Term Frequency)

- Corpus내 나머지 문서들에서 단어의 존재 희소성 (IDF, Inverse Document Frequency)

- Zhang 등은 텍스트 표현에 대해 TF-iDF, LSI (Latent Semantic Indexing, 잠재 의미 색인), 다중 단어 (Multi-words) 를 사용하여 텍스트 분류에 대해 비교하는 연구를 수행함.

- Ranjan 등은 단어들에 가중치를 할당하기 위해 TF-IDF를 사용했으며, LSTM (Long Short-Term Memory) 신경망을 사용하여 문서들을 분류했음.

- 더욱이, 일부 연구들은 분류 업무를 수행하는 주요 문서 표현 방법으로 TF-IDF의 다른 형태 (이형, Variants) 또는 확장판을 사용해왔음.

또 다른 유명한 문서 표현 방법은 토픽 모델링 (Topic Modeling) 을 기반으로 함.

- 토픽 모델링의 주요 목적은 문서가 특정한 확률적 과정 (Stochastic Process, ex : 마르코프, 포아송, 시계열 등) 에 의해 생성된다는 가정을 바탕으로 한 Corpus에 따라 근본적인 테마 (Theme) 를 정의하는 것임.

- LDA (Latent Dirichlet Allocation, 잠재 디리클레 할당) 은 가장 기본적이고 유명한 토픽 모델링의 구현임.

- 일단, LDA가 Corpus 한 개를 바탕으로 훈련되면, 두 가지 Output을 생성함 :

- 주제 별 용어 분포 (Term Distribution per Topic)

- 문서 별 토픽 분포 (Topic Distribution per Document)

- 문서 분류에서 2번의 Output이 문서 표현 방법에 사용됨.

- Biel 등은 토픽 모델링 뿐만 아니라 문서 분류와 협업 필터링 (Collaborative Filtering) 같은 다른 문서 처리 작업들에 LDA를 적용했음.

- Biro 등은 스팸 필터링 (Spam Filtering) 에 LDA를 사용 했고, 다른 기존 문서 표현 방법들과 비교했을 때, 더 높은 정확도 (Accuracy) 를 달성했음.

- 비록 LDA가 레이블 정보를 사용하지 않는 비지도학습 (Unsupervised Learning) 이지만, Wang 등은 LDA 기반 문서 표현에 더해 레이블 정보를 사용하여 문서 분류 성능을 향상시키기 위한 시도를 하였음.

최근에는 Doc2Vec이 다양한 영역에서 문서 분류 작업에 성공적으로 사용되어 왔음.

- Doc2Vec은 Word2Vec의 자연 확장이며, Doc2Vec의 주요 업무는 문서 내부의 Target 단어의 정보와 Target 단어 주변의 단어들을 이용하여 신경망을 학습하고, 하나의 문서에 적절한 분산 표현 (Distributed Representation) 을 결정 하는 것임.

- 이전 연구들은 Doc2Vec이 IMDB Dataset을 이용한 감성 분류 (Sentiment Classification), 뉴스 분류 (News Categorization), 토론 질문 표절 (Forum Question Duplication) 과 같은 다양한 영역에서 다른 문서 분류 방법들보다 더 높은 분류 정확도를 냈음.

3. Method : Multi-co-training

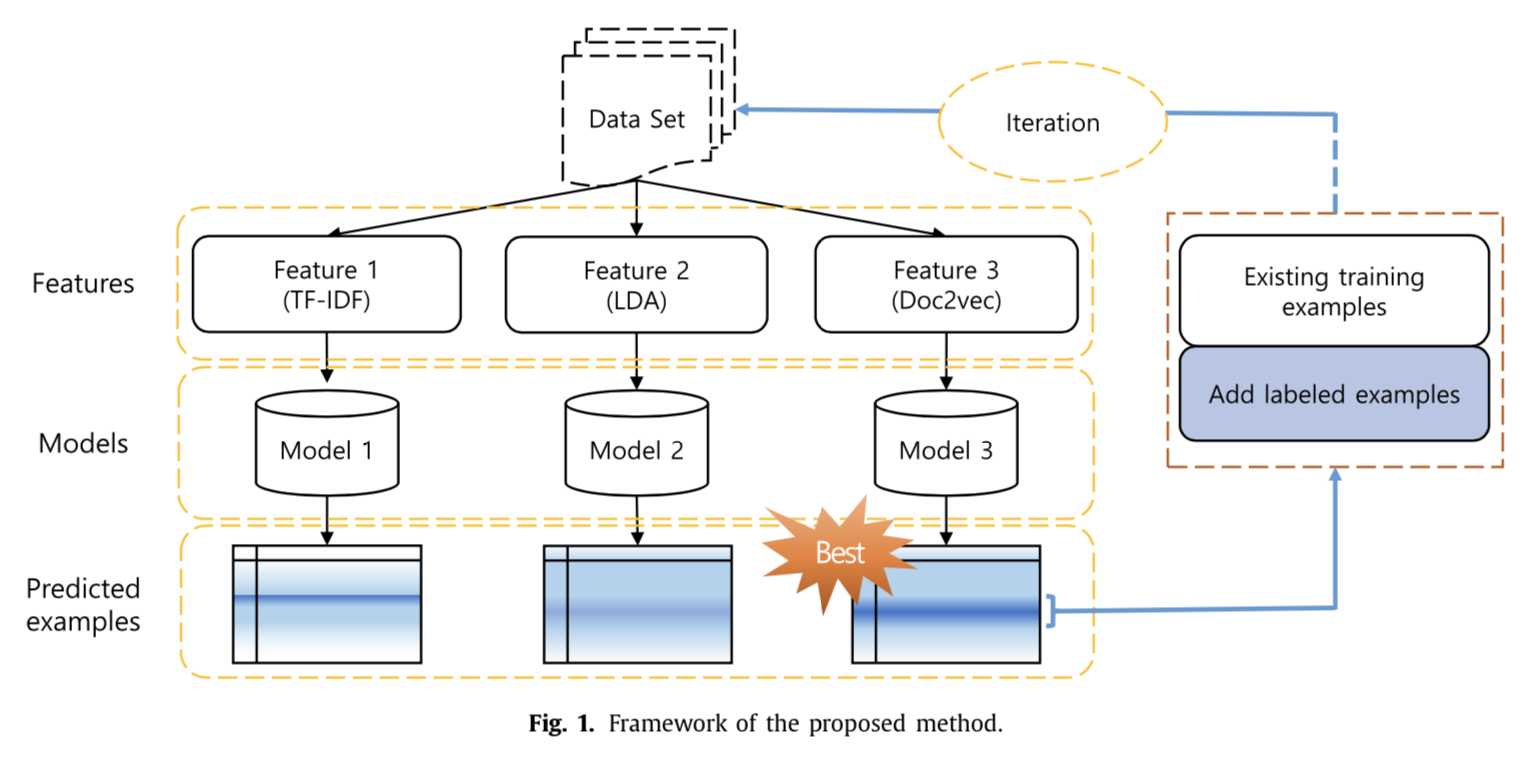

- 제시된 MCT 방법은 Fig. 1에서 설명함.

- 각 문서는 세 개의 문서 표현 방법들을 바탕으로 세 개의 수치 벡터 (Numerical Vectors, 세 개의 Feature Sets) 로 변환됨 :

- TF-IDF

- LDA

- Doc2Vec

- 그런 다음, 세 개의 학습 방법 (Learning Scheme) 이 적용됨 :

- 지도 학습 (SL, Supervised Learning)

- 자가 학습 (ST, Self-Training)

- 다중 공동 학습 (MCT, Multi-co-training)

- SL 기반 알고리즘은 레이블이 있는 문서들만 사용하는 반면, ST 기반 알고리즘은 세 가지 Feature Set 중 오직 하나를 바탕으로 훈련되지만 레이블이 없는 데이터를 사용함.

- 반대로, MCT에서는 각 모델이 초기에 단일 Feature Set을 바탕으로 훈련됨.

- 그러나, MCT는 원래 레이블이 없는 예제들에 대해 매우 신뢰성 있는 예측들을 제공하는 다양한 Feature Set을 사용하는 다른 모델들에게 도움을 받음.

3-1. Document Representation (Feature Extraction)

- 세 개의 문서 표현 방법들은 구조화되지 않은 문서를 구조화된 수치 벡터로 변형하기 위해 사용됨 : TF-IDF, LDA, Doc2Vec.

3-1-1. Term Frequency-Inverse Document Frequency (TF-IDF)

- TF-IDF는 문서 표현의 가장 기본적인 형태이며, 선택된 세 개의 표현 방법 중 가장 오래된 역사를 가지고 있음.

- 이 방법은 문서가 그 문서에서 사용되는 단어들의 모임으로 표현될 수 있다는 Bag-of-Words 기반임.

- 또한, TF-IDF는 만약 단어가 문서에서 중요하다면, 해당 단어는 해당 문서 안에서 반복적으로 나타나야 하는 (전자, Former) 반면 다른 문서들에서는 거의 나타나지 않아야 한다 (후자, Latter) 는 것을 가정함.

- TF는 전자의 가정과 연관되어 있으며, IDF는 후자의 가정과 연관되어 있음.

- 파라미터 tf_ij 는 문서 j에서 단어 i의 출현 횟수로 정의 됨. 이 값이 클수록 그 단어는 더 중요함.

- 파라미터 df_i 는 단어 i가 적어도 한 번 출현한 문서들의 수임. 만약 단어 i가 문서 j에서 중요하다고 간주 되면, 그 단어는 큰 TF(tf_ij) 와 작은 DF(df_i) 값을 가져야 함.

- 예를 들어, 'a'와 'the'와 같은 관사들과 'it', 'this', 'that', 'those'와 같은 대명사들은 빈번하게 문서에 등장할 것임.

- 그러나, 위 단어들은 모든 문서에 만연하기 때문에 해당 문서에서 중요한 단어들이라고 할 수 없음.

- 따라서, TF-IDF는 아래의 식 Eq. (1) 로 정의됨 :

- IDF는 Corpus에 있는 총 문서 수의 로그와 IDF 평활화 (Smoothing) 를 사용하여 단어 i의 문서 빈도 비율을 0으로 나눠지지 않게 함.

- 우리는 Corpus에 대해 높은 TF-IDF 점수를 가진 단어를 평균적으로 선택함.

3-1-2. Latent Dirichlet Allocation (LDA)

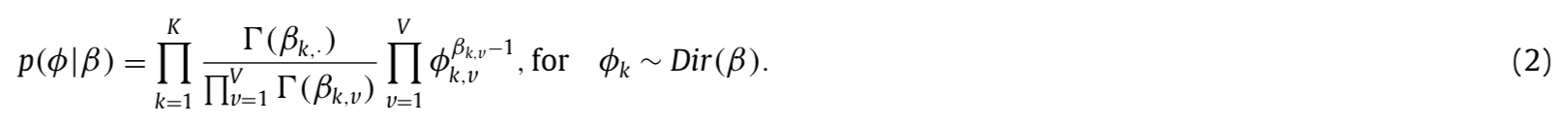

LDA의 주요 목적은 하나의 문서가 사전 확률 과정 (Pre-defined Probabilistic Process) 을 거쳐 생성된다는 가정을 하고, 각 문서의 단어 빈도수를 바탕으로 특정한 Corpus를 관통하는 잠재적 토픽이나 테마를 식별하는 것임.

- 따라서, LDA는 비지도 토픽 생성 모델로 고려될 수 있음.

- LDA는 문서가 토픽 분포에 의해 특징 지어지는 반면, 토픽은 단어 분포에 의해 특징 지어진다고 가정함.

- 따라서, 문서 별 토픽 확률 분포 θ 와 토픽별 단어 확률 분포 φ 는 각 문서가 Fig. 2에 설명된 절차에 의해 생성된다는 가정을 바탕으로 특정한 Corpus를 사용하여 추측됨.

LDA의 문서 생성 과정은 다음과 같음 :

- 첫 번째로, 주제별 단어 분포 φ_k 는 하이퍼파라미터 β를 이용하여 디리클레 분포에서 샘플링 (Sampled) 됨.

- 두 번째로, 문서의 토픽 분포 θ 는 Eq. (3) 에서 표현된 것과 같이, 하이퍼파라미터 α를 이용하여 디리클레 분포에서샘플링 (Sampled) 됨.

- 단어 별 토픽 할당인 잠재 변수 z_n 은 파라미터 θ 를 이용한 Eq. (4)에 표현된 다중 분포 (Multinomial Distribution) 을 따름.

- 그리고 Eq. (5)의 φ_k 는 파라미터 β를 이용한 디리클레 분포를 따름.

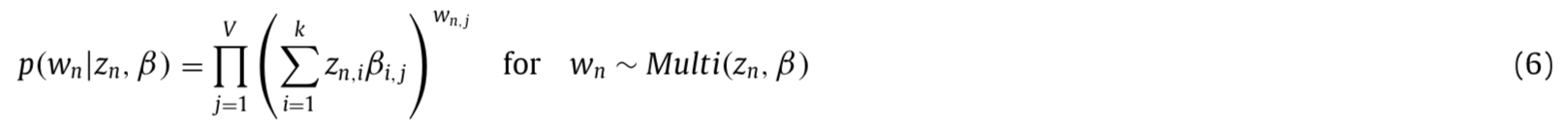

- 마지막으로, 단어 w_n 은 Eq. (6)에 표현된 z_n 과 β를 사용한 다중 분포 (Multinomial Distribution)

- α와 β가 주어지면 θ, z, d를 이용한 결합 분포 (Joint Distribution) 는 Eq. (7) 에 표현된 d 분포를 얻기 위해 먼저 형성됨.

- Eq. (7) 식의 잠재 변수들의 사후 확률 (Posterior Probability) 은 가변적인 기대값 최대화 (Variational Expectation-Maximization) 또는 Collased Gibbs Sampling 을 통해 얻을 수 있음.

- 만약 문서내 K개의 토픽 비율과 같은 문서 Feature가 LDA 형식에 따라 문서와 단어의 관계로부터 추출되는 경우, LDA는 TF-IDF 또는 bigram 같은 다른 문서 표현 방법들을 이용한 문서 분류 보다 더 높은 성능을 낼 수 있음.

3-1-3. Document to vector (Doc2Vec)

단어를 고정된 크기의 수치 벡터로 변형하는 가장 간단한 방법인 원-핫 인코딩은 두 가지 치명적인 결점을 보임.

- 원-핫 인코딩 내부에서 단어 벡터의 차원수가 일반적으로 수십만개가 넘는 Corpus의 유일 단어 갯수와 동등하기 때문에 많은 양의 메모리 공간을 요구함.

- 원-핫 인코딩은 어떤 두 단어의 내적이라도 0이 되기 때문에 단어 사이의 의미적인 관계들을 보존할 수 없음. 즉, 모든 단어들은 서로 독립적이라는 것임.

- 이러한 제약들을 극복하기 위해서, Mikolov 등은 Word2Vec으로 불리는 신경망 기반 단어 표현 방법을 제시했음 ( Fig. 3(a) ).

- 훈련 단어들 w_1, w_2, ..., w_T의 연속이 주어졌을 때, Word2Vec의 목표는 아래와 같은 예측된 로그 확률을 최대화 하는 것임.

- k는 문맥정보를 보존할 수 있는 윈도우 크기임. 예측은 일반적으로 아래의 소프트맥스 (Softmax) 함수를 사용하는 다중 클래스 분류를 통해 수행됨.

- 각각의 y_i 는 아래의 식을 사용하여 계산된 순전파 (Feed-Forward) 신경망의 i번째 Output 값임.

- b : 은닉층 (Hidden Layer) 와 출력층 (Output Layer) 사이의 편향 (bias).

- U : 은닉층과 출력층 사이의 가중치 행렬 (Weight Matrix).

- h : 문맥 단어들의 평균 또는 연속 (Average or Concatenation).

- W : 워드 임베딩 행렬 (Word Embedding Matrix).

Doc2Vec은 다양한 문서들 사이의 의미적 관계를 보존하기 위해 단락 (Paragraph) 또는 더 큰 문서에서 충분하고 연속적인 벡터를 결정하기 위한 Word2Vec의 확장판임.

- Word2Vec과 유사한 방식으로, 각 단어는 d-차원이며 연속적인 벡터 (d < < |V|, Corpus 내에서 어휘 (Vocabulary) 의 크기임. ) 로 표현됨.

- 게다가, 문서 자신도 Fig. 3 (b) 에 보이는 것처럼 단어 벡터들과 동일한 공간에서 연속적인 벡터로 표현됨.

- Doc2Vec에서, 각 문서는 행렬 D의 열에 의해 표현되는 유일한 벡터로 맵핑 (Mapped) 됨.

- 반면, 각 단어은 행렬 W의 열에 의해 표현되는 유일한 벡터로 맵핑 (Mapped) 됨.

- 따라서, 신경 모형에서 유일한 변경점은 아래 Eq. (11) 처럼 Eq. (10) 에서 D의 추가임.

- 일단 망이 충분히 훈련되면, 우리는 Corpus 내 각 문서의 분산 표현 (Distributed Representation) 을 얻을 수 있음.

- 결국, 이 분산 표현은 클러스터링 또는 분류 같은 이후에 나오는 텍스트 마이닝 작업들에 사용될 수 있음.

- 이 연구에서, 우리는 PV-DM, PV-DBOW 방법 모두를 훈련했으며, 두 방법은 Doc2Vec 모델의 주요 구조이고, 원본의 저자들이 제안한 것과 같이 분류 수행 성능을 향상시키기 위해 저자들이 제안한 연속된 벡터를 사용했음.

3-2. Multi-co-training

3-2-1. Co-training: Theoretical Overview

Co-training은 데이터 공간에서 전체 Feature Set이 두 개의 상호 배제 집합 (Two Mutually Exclusive Sets) 으로 나눠 질 수 있다는 가정이 바탕임.

- 즉, X = X1 ∪ X2, 그리고 각 예제들은 X를 따르는 D분포와 관련된 0이 아닌 확률을 가진 정렬된 순서쌍 x = (x1 ∪ x2) 을 가짐.

- 또한, co-training은 개별적으로 X = X1 그리고 X = X2에 부합하는 목표 함수 (Target Function) C1 과 C2 의 집합을 가진다.

- co-training이 사용되는 절차는 알고리즘 1을 통해 설명됨.

- co-training의 주요 개념은 우리가 예제를 두 개의 독립적인 View (view A, view B) 로 조사할 수 있는가의 여부임.

- view (A) 는 view (B) 보다 레이블이 없는 특정한 예제들을 더 신뢰성 있게 분류할 수 있음.

- 이러한 예제들은 자신의 분류 수행을 향상시키기 위해 view B의 데이터를 사용하여 훈련되는 Classifier에 제공될 수 있음. 게다가, 반대 상황 또한 가능함.

- 이 개념은 레이블이 있는 특정한 초기 Feature sets X^L_1 과 X^L_2 만을 바탕으로 모델 f_A 와 f_B 를 개별적으로 구축하고 (알고리즘 1의 6-7 단계), 각 Classifier f 를 사용하여 레이블이 없는 예제 X^U 를 예측함으로써 구현됨.

- 결국, 각 Classifier에 의해 신뢰성 있게 예측된 예제들 U (알고리즘 1의 10 ~ 11번째 줄) 은 예측된 레이블을 가지고 다른 Classifier의 레이블이 있는 Feature Set X^L 에 추가됨 (알고리즘 1의 12 ~ 14번째 줄).

Co-training을 효과적으로 수행하기 위해 Feature Set에 대한 두 가지 가정을 바탕으로 함.

- 인스턴스 분포 D는 목표 함수 (Target Function, f = (f1, f2) ) 와 호환이 가능할 것임. 즉, 각 Feature Set이 Classifier를 학습하는데 충분하다는 것임.

- Feature Set들은 서로 독립적일 것임. 예를 들어, 웹페이지 분류에서, 콘텐츠와 하이퍼 링크들은 Nigam과 Ghani의 co-training을 위한 두 개의 Feature set으로 사용됨.

3-2-2. Proposed Method

- co-training과 유사한 방식으로, 우리는 세 가지 문서 표현 방법들을 사용했음 : TF-IDF, LDA, Doc2Vec.

- MCT의 과정은 알고리즘 2를 통해 설명됨. 그리고 보기의 예제는 Fig. 4를 통해 제공됨.

- 처음에, 각 문서는 TF-IDF, LDA, Doc2Vec을 바탕으로 세 가지 Feature 벡터로 변형됨 (알고리즘 2의 7번째 줄).

- TF-IDF가 간단하고 갯수 기반 방법이기 때문에, 표현 모델은 학습될 필요가 없는 반면, LDA와 Doc2Vec 모델은 특정한 Corpus를 바탕으로 훈련 됨.

- 일단 문서 표현이 완료되면, 세 가지 Classifier는 각각 해당되는 Feature Set을 사용하여 레이블이 있는 예제들만을 가지고 훈련됨 (알고리즘 2의 11번째 줄).

- 그런 다음, 세 가지 Classifier는 레이블이 없는 문서들을 예측하고 그 예측들에 대한 신뢰 수준을 계산함 (알고리즘 2의 12번째 줄).

- 한 개의 예제에 대한 Classifier의 신뢰 수준은 Classifier가 더 정확하고, 예측된 클래스 확률이 균등하게 분포되있지 않을 때 증가함 (알고리즘 2의 13 ~ 17번째 줄).

- 일단 이러한 매우 신뢰성 있고 레이블이 없는 예제들이 식별되면, 이 예제들은 예측된 클래스 레이블을 가지고 레이블이 있는 Training Set에 추가됨 (알고리즘 2의 18 ~ 21번째 줄).

- 우리는 γ 의 반복과 관련하여 Classifier의 성능을 점진적으로 향상시키기 위해 레이블이 있는 예제 N의 수를 조정 했음 (알고리즘 2의 11 ~ 21번째 줄).

4. Experiments

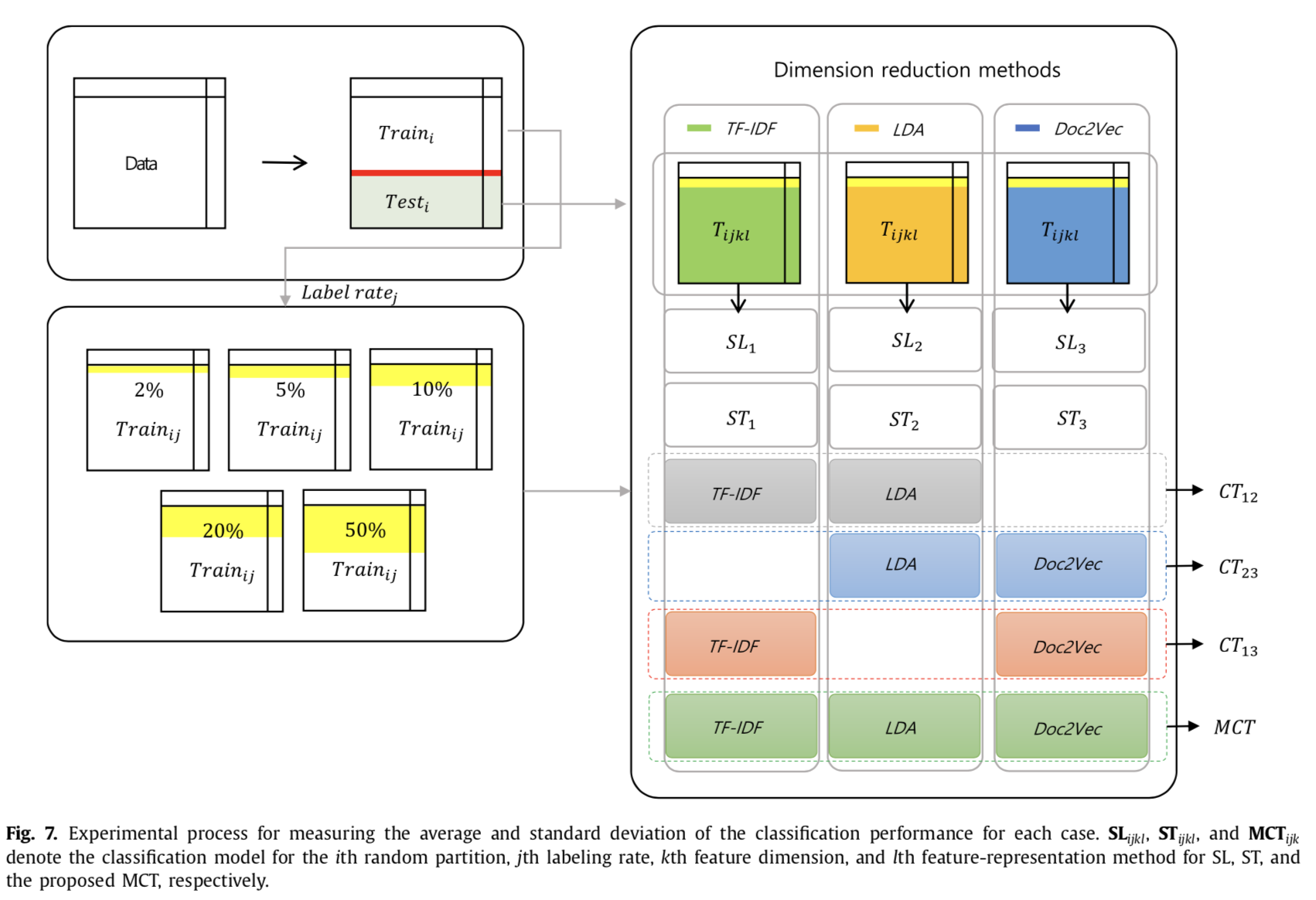

제시된 MCT 방법을 증명하기 위해서, 우리는 Fig. 5에 설명된 것 처럼 비교 실험을 실시했음.

- 동일한 텍스트 전처리 (Text-Preprocessing) 기술들이 선택된 다섯 개의 Dataset에 적용됨.

- Dataset 내 각 문서는 TF-IDF, LDA, Doc2Vec을 기반으로 세 가지 벡터 집합들로 변형됨.

- 세 가지 문서 표현 방법들을 바탕으로 네 가지 학습 전략들이 사용됨 :

- 순수 SL (Purely Supervised Learning).

- ST기반 SSL (Self-Training based on Semi-Supervised Learning).

- Co-training.

- MCT (Multi-co-training).

- 결과로, 10개의 전략들은 Table 1에서 비교됨. 우리는 또한 문서 표현의 차원과 레이블이 있는 데이터 비율을 달리했음.

4-1. Data Description

- 문서 분류에서 유명한 다섯 개의 Dataset을 선택함 :

- Reuter-21578

- 20 Newsgroup

- Ohsumed

- Reuters-50-50

- SemEval

- Corpus내 문서의 길이는 짧은 문장 (SemEval) 부터 긴 문서 (Reuter-21587) 까지 달리함.

- Reuter-21587을 제외한 모든 Dataset은 원래 미리 정의된 (Predefined) 파티션 집합들 (Training / Test sets) 을 가지고 다중 클래스 분류에 사용됐음.

- Reuter-21587 Dataset에서, 우리는 아래에서 쓰인 가장 빈번하게 사용되는 10가지 목록들을 선택했음.

http://www.jmlr.org/papers/volume2/tong01a/tong01a.pdf

Support Vector Machine Active Learning with Applications to Text Classification

4-2. Classification Algorithms and Parameter Settings

이 연구에서, 나이브 베이지안 분류 (Naive Bayesian, NB) 와 랜덤 포레스트 (Random Forest, RF) 가 기본 Classifier로 채택됨.

- 두 Classifier 모두 계산 효율성과 실제 시스템에서의 편리한 구현 때문에 텍스트 분류 작업에서 널리 사용되어져 왔음.

- 인공 신경망과 SVM 같은 다른 머신러닝 기반 분류 알고리즘과 비교할 때, NB는 특정한 알고리즘 파라미터를 포함하지 않으며, 일반적으로 이러한 파라미터는 최적화를 위해 큰 계산 부담을 야기함.

- NB에서, 우리는 각 변수들 정규분포를 따른다고 가정함.

- 우리는 테스트 문서들을 추론하기 위해 각 변수들의 평균과 표준 편차를 추측했음.

- 또한, 우리는 라플라스 평활화 (Laplace Smoothing) 를 채택함.

- RF는 특정한 알고리즘 파라미터를 포함함 (트리의 수, 분리 (Split) 를 위해 고려 되는 변수 (Variable) 의 수).

- 그러나, RF의 수행은 충분히 큰 크기의 앙상블 모집단을 확보할 수 있다면, 성능은 그러한 파라미터들의 변화에 상당히 견고함.

- 우리는 이 연구에서 앙상블 모집단을 100개 준비함.

Classifier의 성능에 영향을 미칠 수 있는 두 가지 중요한 데이터 의존 파라미터들이 있음 :

- 레이블이 있는 예제의 비율

- 문서에 대한 Feature의 수 (차원의 수)

- 다양한 레이블이 있는 비율 조건 에서 SSL 접근법들의 효과를 이용하기 위해서, 우리는 2% 와 50% 사이에 다섯개의 레이블링 비율들을 테스트 했음.

- 순수 지도학습 Classifier는 레이블이 있는 데이터만을 사용하여 훈련되는 반면, SSL 방법들은 훈련동안 레이블이 없는 데이터도 사용함.

- 게다가, 우리는 8 ~ 300까지 차원을 다양하게 하여 표현 차원 (Feature의 수) 의 효과를 테스트 했음.

- LDA에서, 우리는 α = 0.1, β = 1로 설정함. 데이터의 구체적인 파라미터 설정들은 Table 3에서 주어짐.

4-3. Performance Measurement

우리는 다른 연구들의 결과와 비교하기 위해 두 가지 성능 측정 지표를 사용했음 : SemEval Dataset의 Pos itive, Negative 클래스의 평균 F1 Score / 그 외 Dataset의 각 클래스의 Precision, Recall의 손익 분기점.

- 평균 F1 수치는 SemEval Dataset을 이용한 경쟁에서 사용되는 주요한 성능 층정 지표이기 때문에 채택됐음. - Former (전자)

- Precision, Recall의 클래스 범위 손익 분기점 (Class-Wise Break-Even Point) 은 나머지 Dataset에서 사용됐음. - Latter (후자)

- 전자는 Dataset 수준의 성능 측정 지표인 반면, 후자는 클래스 수준 성능 측정 지표라는 것이 주목할 만함.

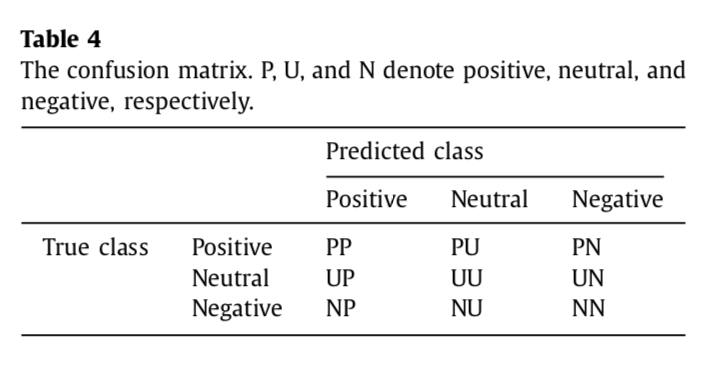

SemEval Dataset에서는 세 가지 클래스 (Positive, Neutal, Negative) 가 표현됨.

- 따라서, Classifier의 혼동행렬 (Confusion Matrix) 은 Table 4와 같이 요약될 수 있음. Positive와 Negative 클래스의 평균 F1 측정지표는 Eq. (12) ~ (15) 를 사용하여 계산할 수 있음.

Fig. 6은 Precision과 Recall의 손익 분기점을 설명함.

- Trade-Off가 Precision과 Recall 사이에 존재하기 때문에, 우리는 두 가지가 동일해지는 곳에서 각 클래스이 Cut-Offf를 얻었음 : 값이 높아질 수록 Classifier도 더 효과적임.

통계적으로 신뢰할만한 결과들을 얻기 위해서, 우리는 Fig. 7에 설명된 것처럼 이 과정을 10번 반복했음. 그리고 수행성능 측정치의 평균과 표준편차를 계산했음.

- 첫 번째로, 우리는 사전에 파티션 집합으로 나눠진 전체 Dataset을 얻었음.

- 두 번째 단계에서, 레이블이 있는 집합의 비율들만 유지됨 (2, 5, 10, 20, 50%).

- 세 번째 단계에서, Training Set 내 각 문서는 각 Classifier를 가지고 시행한 10-fold 교차 검증 (Cross Validation) 에 의해 최적화된 차원에 따라 다른 Feature 벡터들로 변형됨.

- TF-IDF, LDA, Doc2Vec이 레이블이 있는 예제들을 샘플링하기 전에 Training Dataset을 바탕으로 구축되거나 훈련된다는 사실을 주목해야 함.

- 즉, 특정 표현 방법을 이용한 단일 문서의 표현 벡터와 차원은 반복적인 과정동안 동일함.

- 결국, SL, ST, MCT 기반 분류 모델들은 훈련되고, 모델의 분류 수행 능력들은 사전에 정의된 (Pre-defined) Test Set을 사용하여 평가됨.

5. Result

Table 5는 10-fold 교차검증에 의해 최적화 된 Feature 차원의 수를 요약함.

- 일반적으로, TF-IDF는 가장 높은 차원을 요구하며, 뒤이어 LDA와 Doc2Vec임.

- 이 결과는 비록 TF-IDF가 분류 작업에서 가장 중요한 단어들을 선택했다는 점에서는 간단하지만, 나머지 두 방법들보다 더 희소한 표현 방법임 (More Sparse Representation) : TF-IDF에서 수많은 Feature 값이 0이 될 수 있음.

- 한편, LDA와 Doc2Vec은 분산 표현을 학습하고, 더 적은 수의 Feature를 가지고 더 많은 정보를 포함할 수 있음.

- LDA와 Doc2Vec의 최적의 차원은 Dataset과 분류 알고리즘에 의존적임.

- RF는 보통 LDA와 비교했을 때, Doc2Vec에서 더 적은 차원을 요구함.

MCT와 co-training의 중요한 전제들 중 하나는 서로 다른 Feature Set은 서로 독립적이라는 것임.

- 따라서, 한 Feature Set에서 획득한 구체적인 유용한 정보들은 전반적인 성능을 향상시키기 위해 나머지 Feature Set에 제공됨.

- 이 가정을 확인하기 위해, 우리는 Table 6에서 처럼 두 가지 Feature Set 사이에서 본 페로니 교정 (Bon-ferroni Correction) 으로 조정된 피어슨 상관계수 (Pearson Correlation) 가설검정을 실시했음.

- 귀무가설 (H_0) 은 두 Feature Set 사이의 상관관계는 0이라는 것임. 즉, 두 Feature Set이 상관관계가 없음.

- 대립가설 (H_1) 은 두 Feature Set 사이의 상관관계는 0이 아니라는 것임. 즉, 더 또는 덜 상관관계가 있음.

- 각 셀의 값은 두 가지 Feature Set에서 각 Dataset에 대해 기각된 가설들의 비율임. 값이 작을수록, Feature 독립성은 더 강하게 지지됨.

- TF-IDF와 Doc2Vec의 기각비율이 다섯 개의 Dataset에서 0.001보다 작기 때문에 독립적이라고 고려할 수 있음.

- 비록 LDA와 Doc2Vec, TF-IDF와 LDA 사이의 일부 기각비율이 상대적으로 다른 상황에서의 비율보다 높지만, 그 비율 또한 0.05보다 작음.

- 이러한 점은 두 가지 Feature Set이 독립적이라는 것을 나타냄.

각 학습 전략에서, 우리는 레이블 비율 (2, 5, 10, 20, 50%) 과 분류 알고리즘 (NB, RF) 을 달리하여 10가지 분류 모델들을 훈련했음.

- 게다가, 클래스 수준 성능 행렬은 SemEval Dataset 외에 네 가지 Dataset으로 계산 됨.

- 예를 들어, 우리는 Reuters-21587에서 10개의 Recall, Precision의 손익 분기점을 가지며, Dataset의 각 훈련 전략에 대한 100개의 성능 행렬 (Performance Metric) 값의 결과를 냄.

- 이러한 성능 값들이 클래스들에 따라 달라지기 때문에 다른 요약 통계량들의 단순 평균값은 다른 학습 전략들을 이용한 MCT와 비교하기에 적절하지 않을 것임.

- 따라서, 우리는 비슷한 상황에서 각 전략의 수행 행렬 값의 순위를 비교했음.

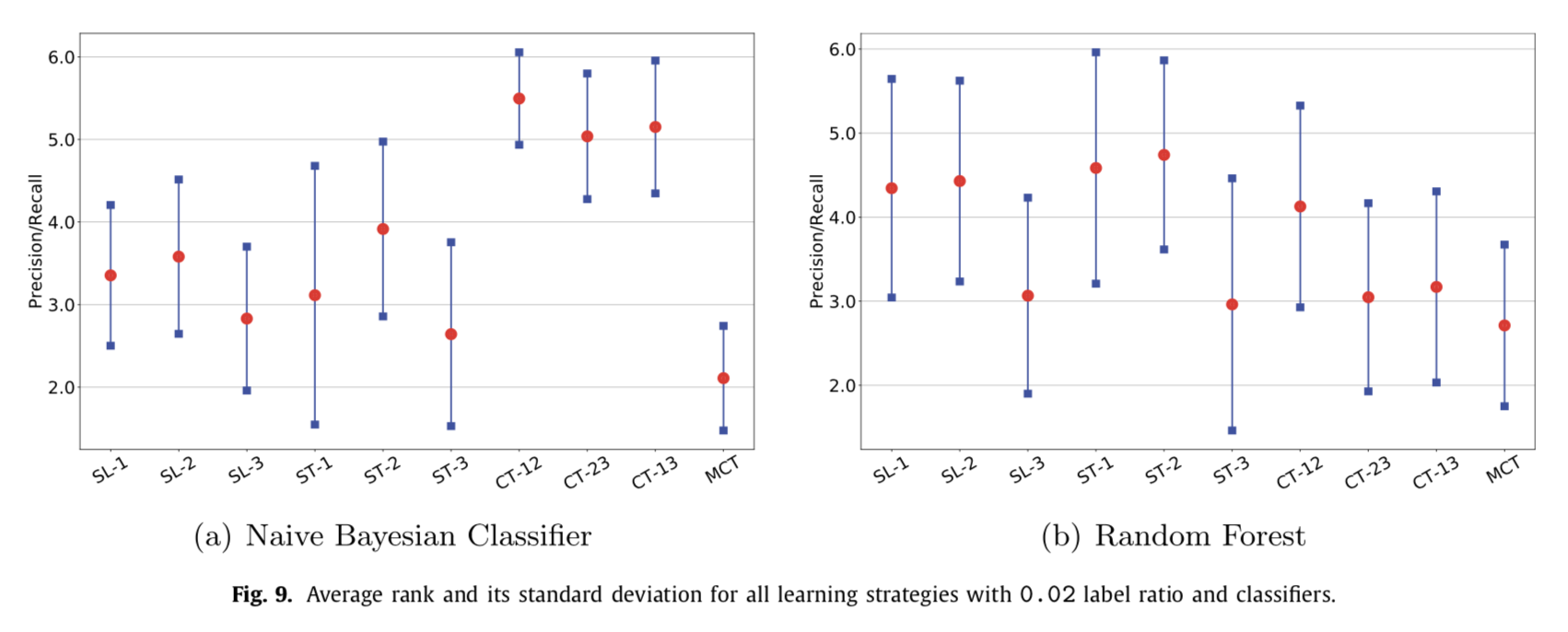

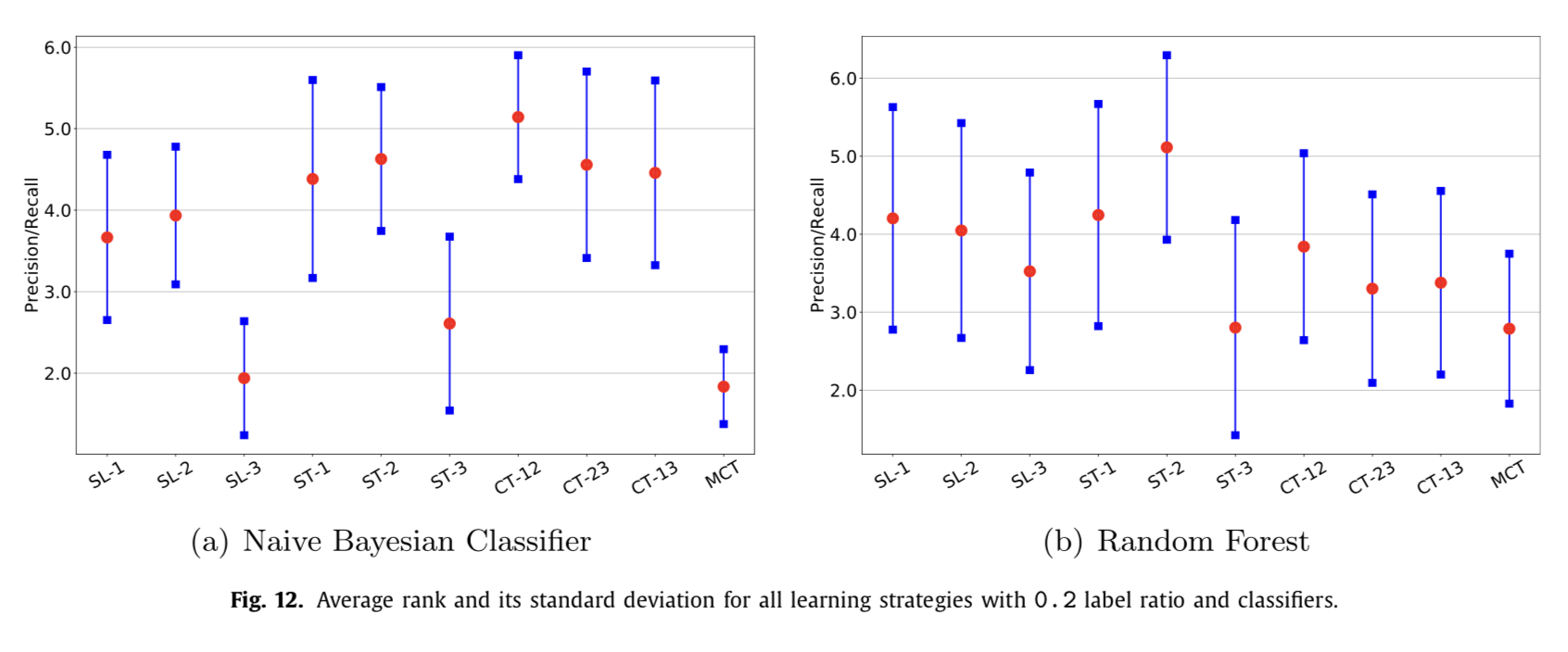

Fig. 8은 NB와 RF에 대해 각 학습 전략의 평균 순위와 표준 편차를 보여줌.

- 위와 같이, 이러한 순위 구성들은 각 학습 전략들에 대해 520가지 경우를 바탕으로 매겨짐. 평균 순위 값이 작을수록, 분류 성능은 더 높음.

- 게다가, 표준편차 기둥이 좁을수록, 분류모델은 더 견고함.

- Feature 표현 방법들 중에서, Doc2Vec은 가장 높은 분류 성능 결과를 내는 반면, TF-IDF와 LDA는 유사한 성능을 냈음.

- 주목할 만한 관측은 간단한 분류 알고리즘이 시행 됐을 때, 기존 SSL 방법들은 많은 경우에서 분류 성능을 향상시키지 못했다는 것임.

- 예를 들어, NB Classifier를 가지고, SL-1 (TF-IDF Feature를 이용한 ST) 의 평균 순위는 ST-1의 평균 순위보다 근소하게 작았으며, CT-12의 평균 순위는 SL-1과 SL-2 평균순위보다 더 높았음.

- 유사한 관계들이 나머지 Feature에서도 관측됐음.

- 한편, 상대적으로 복잡한 분류 알고리즘을 이용한 co-training은 분류 성능을 향상시키거나 성능을 더 견고하게 만드는 것을 가능하게 했음.

Fig. 8은 제시된 MCT가 기존 SSL 방법들의 분류 성능을 향상시킨다는 것을 설명함.

- 성능 향상은 NB Classifier를 이용하면 더 명확해짐 : MCT의 평균 순위가 10가지 학습 전략 중 두 번째이고, 표준 편차는 거의 첫 번째임.

- 비록 RF를 이용한 MCT의 성능 향상이 NB만큼 크지 않지만, MCT의 평균 순위는 학습 전략들 중 가장 낮고, 가장 작은 순위 편차를 가졌음.

Fig. 8이 가장 추상적인 정보를 제공하기 때문에, 우리는 Fig. 9 ~ 13에서 클래스 레이블 비율에 대한 성능 순위를 비교했음.

- NB, RF 모두에서, 제시된 MCT는 모든 클래스 레이블 비율에서 가장 높은 분류 수행을 달성했음.

- 다른 관측치 들은 다음과 같음 : 클래스 레이블 비율이 매우 낮을 경우 (2, 5%), co-training은 NB가 기본 Classifier로 사용 됐을 때, 분류 성능을 악화시켰음.

- 게다가, NB Classifier를 이용하여, TF-IDF 표현을 이용한 ST는 ST-1의 표준편차가 SL-1보다 더 커졌기 때문에 덜 견고해짐.

- RF를 기본 Classifier로 사용했을 때, 성능 순위는 클래스 레이블 비율에 대해 상당히 변화하지는 않음.

- MCT는 대부분의 레이블 비율에서 가장 높은 성능 결과를 냈고, ST-3이 그 뒤를 이었음.

- 게다가, 성능 순위는 RF를 사용할 때 더 빈번하게 변화함. 따라서, 보통 특정한 학습 전략은 NB와 비교했을 때, 평균 순위는 더 높고 표준 편차도 NB에 비해 큼.

6. Conclusion

이 논문에서, 우리는 문서 분류 정확도를 높이기 위해 MCT를 제시했음.

- 세 가지 문서 표현 방법 (TF-IDF, LDA, Doc2Vec) 은 구조화되지 않은 문서들을 실제 값이 있는 벡터들로 변형하는데 사용됐음.

- 레이블이 있는 문서들 보다 레이블이 없는 텍스트 문서들이 실제 문제들로 많이 나타날 때, 우리는 레이블이 없더라도 이용 가능한 데이터를 사용하여 분류 모델을 바꾸기 위해 SSL방법을 채택함.

- 실험 결과들은 제시된 MCT가 기존 SL-, ST-기반 SSL 보다 우수하고 더 견고한 분류 성능을 달성할 수 있다고 증명함 (특히 거친 상황 : (문서가 매우 낮은 차원 벡터로 변형됐을 때, 레이블이 있는 문서들이 거의 없을 때) ).

현재 연구는 확실한 한계를 가지고 있어 앞으로의 연구 방향을 파악하는데 우리를 안내함.

- 비록 Dataset의 클래스들이 균등하게 분포되어 있지 않지만, 클래스 불균형 비율들은 매우 높지 않음.

- 일부 응용 프로그램에서는, 특정한 클래스에 대해 적은 수의 문서들 밖에 없는 반면 다른 클래스들에 대해서는 많은 예제들을 이용할 수 있음.

- 이러한 어려운 상황에서 제시된 MCT를 테스트 하는 것은 효과적일 수 있음.

- 다음으로, 우리 실험에서 사용된 반복적인 알고리즘은 계산 복잡성 관점에서 부담이 될 수 있음.

- 따라서, 조기 정지 또는 불필요한 예제 제거와 같은 효율적인 학습 방법들이 탐색되어야 함.

'Paper > ML (Machine Learning)' 카테고리의 다른 글

| CatBoost: unbiased boosting with categorical features (0) | 2019.09.25 |

|---|---|

| LightGBM: A Highly Efficient Gradient Boosting Decision Tree (1) | 2019.07.07 |

| XGBoost: A Scalable Tree Boosting System (0) | 2019.06.17 |